★ 写真の基礎知識★

写真の基礎知識★

デジタル写真の画質について

データ面からデジタル写真の画質を決める重要な要素は解像度と色の再現性である。

ラスタデータは画素の並びの位置と色のデータしか持っていないのでデータから見るとまあまあ単純である。

解像度

解像度は色々な意味で使われ、しかも混同されるので注意が必要である。

- 持っている画素数(実はモニタ、デジカメ、プリンタなどで意味が異なる)

- 実際に単位長さ当たりに持っている密度としての画素数(主にモニタやプリンタなどの出力デバイスで問題になる)

-

実際に撮影した写真が持っている画素による分解能。1画素で1分解能を持っているのが理想だが実際にはデジカメの最大画素数では、複数の画素でようやく像を分解できるようになる。適切に画素数を縮小することで1画素=1分解能に近づいていく。

ただし画像が縮小されるので全体としての分解能も減少する。

画素数(モニター)

画素数は取り敢えず大きい方が良いと考えれば良さそうな分かり易そうな指数である。

モニタでは、1画素で1分解能と考えて良いが、デジカメでは実際の分解能は画素数だけに遺贈するわけではない点に注意しなければならない。

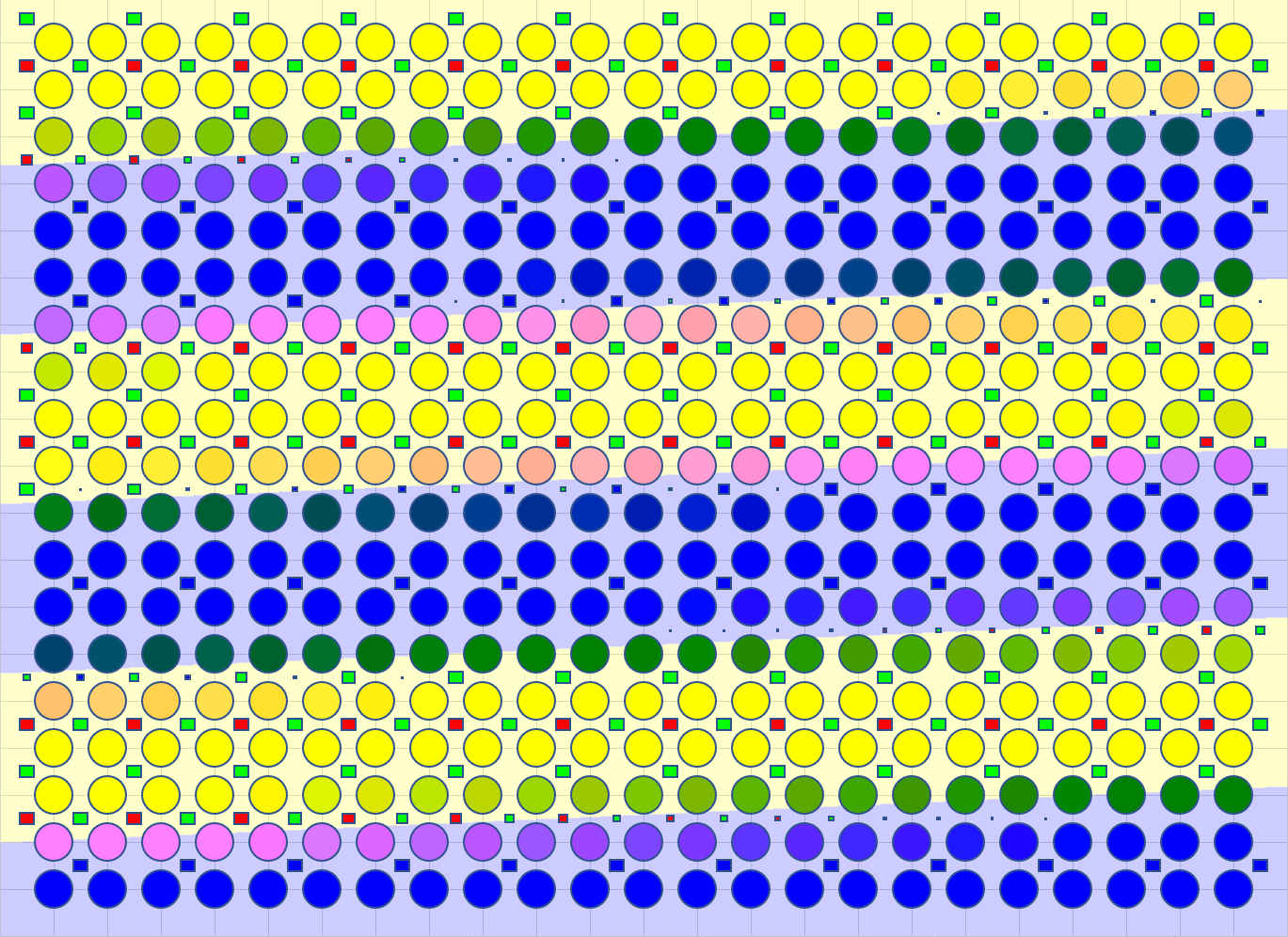

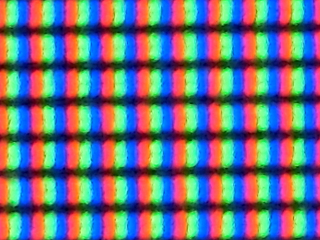

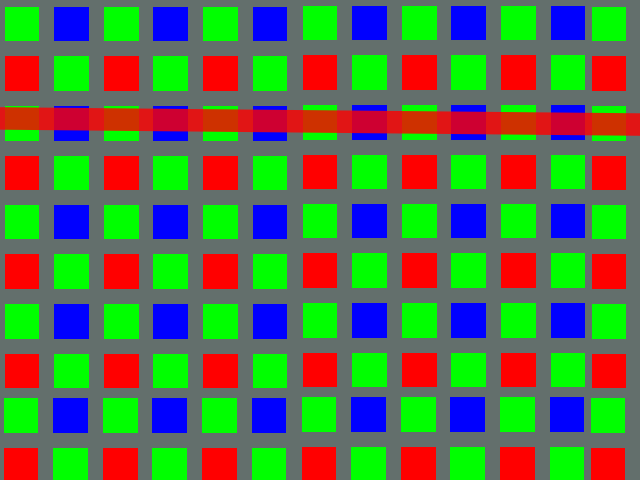

モニターでは、きれいにR(赤),G(緑),B(青)の3原色がきれいに並んでいる。

上の写真は手持ちのモニターをマクロ撮影したものである。左から古い順で

- 24.1インチWUXGA(1920x1200)2008年製

- 21.5インチFHD(1920x1080)TNパネル 2012年製 3D対応

- 27インチ4K(3840x2160) IPSパネル 2018年製

どれもカラーフィルター付きの液晶によって背後からのバックライトしての光を遮ることで各色の明暗を作り出している。

(その他に素子自らが光るモニターとして最近スマホなどでの採用が多い有機EL方式、過去のものとなったプラズマディスプレイがある)

どれも三原色のRGBをひとつの組として(空きのスペースを含めれば)真四角の場所を占めている。モニターの場合はこのRGBの1組が1画素である。

画素数(デジカメ)

古くは、撮像管で、撮像面をスキャンしてアナログ的な信号を取りだしていたが、今では撮像素子をマトリクス上もしくはラインセンサーで線状に配置して光の信号を得る方法がほぼ100%である。

撮像素子であるセンサーの大まかな種類はCCDとCMOSのふたつに分けるのが普通である(ほかにFoveon X3など優れた可能性を持つものもあるが、まだ特殊な部類になる)。

昔はCCDの方が優れていると評価される場合が多かったが、最近では同じ種類でも品質の差が大きく、高いカメラで高級なCMOSが使われる場合も多い。

画素数は、実際に撮影に使われる最大のセンサー数を指す。

製造上の都合で実際の撮影には使われない画素を持つ場合があり、それらを含めて最大画素、実際に撮影に使われるのを有効画素などという、ちょっと詐欺っぽい言い方をする場合もある。この場合は有効画素=画素数と考えれば良い。

最大画素では後で述べる事情で1画素=1分解能とならないが、デジカメについている画素数を現象させる選択の機能は、撮影に使用するセンサーの数を間引くのでなく、少ない画素へと案分する場合が多い。

こうするとある程度の縮小までは、全体の画像としての画素数は減少するが、分解能は上がっていくので、全体としての分解能はそれほど落とさずにファイルサイズは大きく減少できるというメリットがある。

ただし、使用する画素を減少させることで望遠の効果を出したり、画面の縦横の比率を変える場合もある。

実際に使用するカメラの画素の扱い方についてよく確認しておいた方が良い。

撮像素子を線状に並べたものはラインセンサーと呼び、コピー機やスキャナーによく用いられる。センサーか撮影対象を物理的、もしくは反射などの光学的な方法で移動させて広い範囲の像を得る。

これに対して写真用はほぼすべてが縦横マトリクス上に配置されたエリアセンサー型で一発で画像を得る。

画像を得る時間は厳密には一瞬でなく、特にCMOS型では上下の方向があり、上から順に画像を得ていくので画面の上下方法で実際に撮影した時間が部位に異なるので、動く電車を横から取ったときに四角い窓が平行四辺形になるローリングシャッター現象が起きやすい。

CMOSはこのほかにセンサー毎の品質のばらつきを抑えるのが難しいなどの欠点もあるが、半導体の製造技術の応用だけで作り易く、画像処理用のマイコン部分まで一体的に作ることもでき、また消費電力も少ないというメリットもあり、最近の高級カメラでは改良型のCMOSが使われる場合が多い。

カラー画像を得るためには(Foveon X3のような今はまだ野心的な方法もあるが)3原色のフィルターで色別の感度を持った素子を平面上に並べる単板式が主流である。

この色を取得する位置が波長によってずれているということが、このずれのピッチに近い模様を撮影するときに厄介な問題を引き起こす。

ほかに波長選択制反射膜(ダイクロイックミラー)を使って複数の撮像板に投影する多板式が業務用のテレビカメラなどにつかわれている。高性能な色特性を得やすいが、3次元的な高精度とミラーの占める場所が必要という欠点がある。

撮像素子の配置

単板式では各色のセンサーの配置をどのように行ったらいいかという問題が発生する。

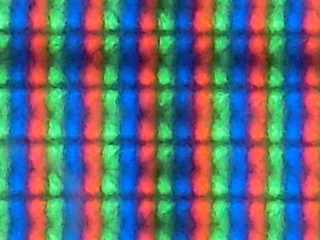

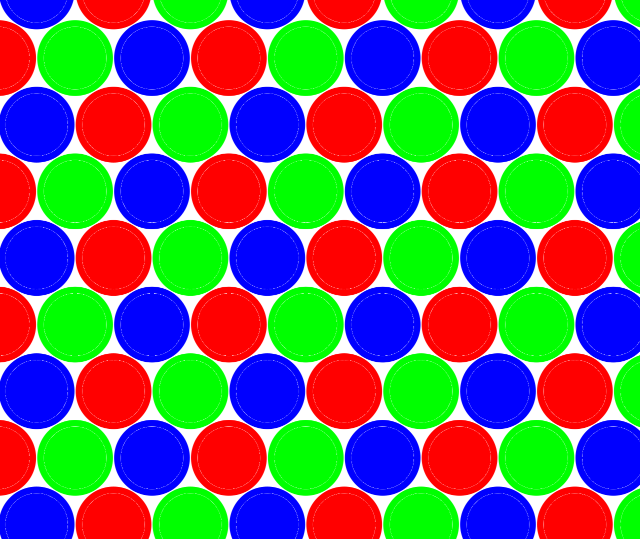

初期の家庭用ビデオカメラの時代から良く説明されてい来た典型的なハイとのパターンのはずである。

初期の家庭用ビデオカメラの時代から良く説明されてい来た典型的なハイとのパターンのはずである。

3原色のフィルターを付けた素子が、無駄なく均等に配置されている一見合理的な方向性の少ない良いパターンである。。

しかし、最近では、このパターンの画をネットでも探すのが難しいくらいまれなパターンになってしまったようだ。

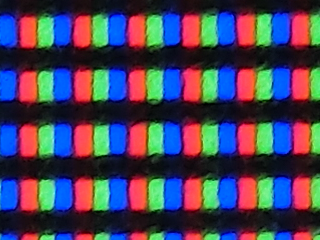

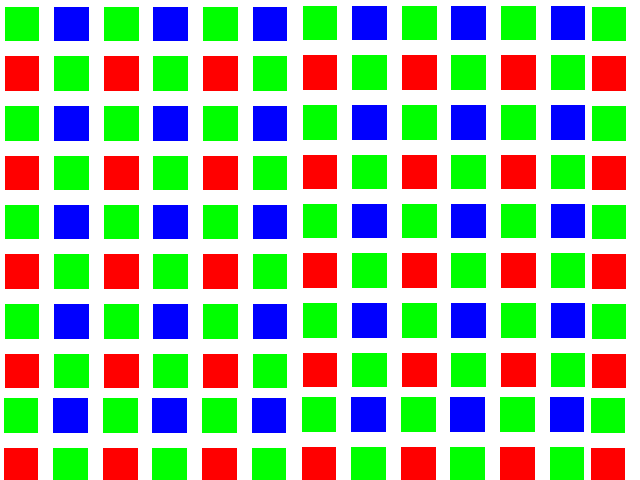

最近では、いつの間にか左の図のようなベイヤー(Bayer)配列が当たり前のようである。このメリットは複雑な六角形にするなどの工夫をしなくても、単純に四角に配置して、しかも人間の眼では高い感度を持つ緑の素子を増やすことが出来て人間の感度に合わせた受光分布を得る上でも都合が良いと利点もあって、どうやら今ではこれが一般的なパターンのようである。

最近では、いつの間にか左の図のようなベイヤー(Bayer)配列が当たり前のようである。このメリットは複雑な六角形にするなどの工夫をしなくても、単純に四角に配置して、しかも人間の眼では高い感度を持つ緑の素子を増やすことが出来て人間の感度に合わせた受光分布を得る上でも都合が良いと利点もあって、どうやら今ではこれが一般的なパターンのようである。

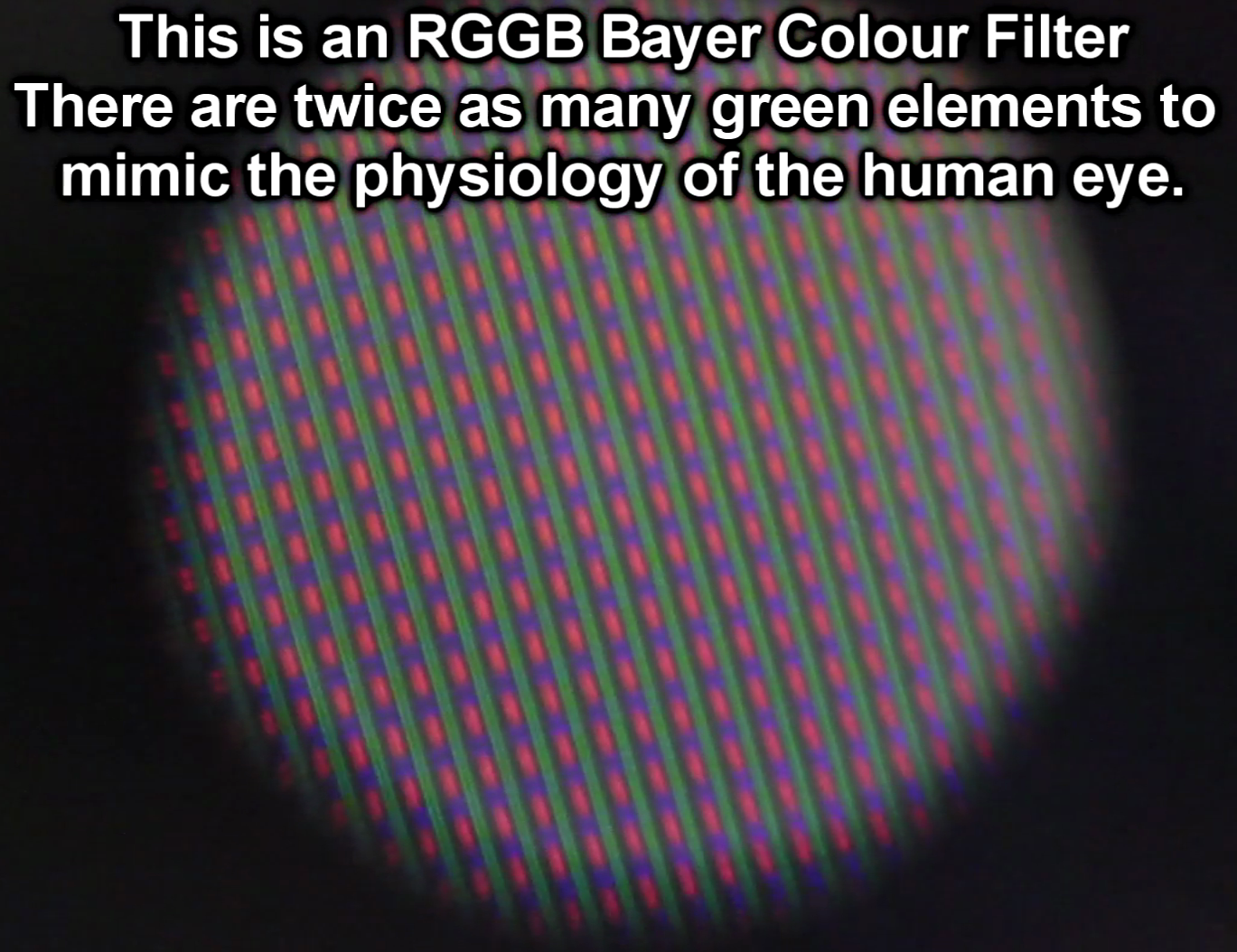

これは英語版のWikiに載っていた、SONYのビデオカメラ用(この業界で高性能で定評がある)のベイヤー配列の写真である。

これは英語版のWikiに載っていた、SONYのビデオカメラ用(この業界で高性能で定評がある)のベイヤー配列の写真である。

(英語版のWikiに載っていた写真)

緑が繋がっているが、ベイヤー配列といっても上の図のような千鳥配列とは限らないようだ。

さて、大部分の撮影装置では、撮像素子を色別のフィルターによって取り入れる光の波長を選択して平面上に並べて配置しているが、実際にこのセンサー面に届く光がセンサーの位置のずれよりも細かい解像度を持っている場合は正確に光を捉えることが出来ずにとんでもない結果になることがある。

たとえば左のBayer配列の図で上から3行目に赤の光が線状にセンサーの幅よりも狭く入った場合、実際この線の幅がセンサーのピッチよりも細いくらいの解像度で入ってくれば、この行では、赤の光がなかったことになってしまう。斜めに入ってきた場合は、赤の成分を感知できる部分とそうでない部分が発生する。

たとえば左のBayer配列の図で上から3行目に赤の光が線状にセンサーの幅よりも狭く入った場合、実際この線の幅がセンサーのピッチよりも細いくらいの解像度で入ってくれば、この行では、赤の光がなかったことになってしまう。斜めに入ってきた場合は、赤の成分を感知できる部分とそうでない部分が発生する。

この後者の色が付いたり付かなかったりするのはモアレによる偽色といわれ、デジタルカメラや精密な印刷の世界で問題になる。

フィルムカメラの場合は、フィルムの粒状性が規則正しくなくバラバラなのでこの偽色は発生しにくいと言われている。

モアレに関しては、規則正しい位相差によって発生すとか何とかいわれると、まるで詐欺の手口に筆禍りそうな気分になる人も多いと思うのでもう少し詳しく見てみよう。

モアレといっても実はいくつかのタイプがあり、それをごっちゃに解説されている場合がある。

モアレ

自然なモアレ

モアレ(フランス語:moiré、英語:moire)とは、規則正しい模様を複数重ね合わせた時に、それらの周期のずれにより視覚的に発生する縞模様のことである。また、規則正しい模様を、デジタル写真などのビットマップ画像にした場合も、画像の画素解像度と模様の周波数のずれが原因で同様の縞模様が発生するがこれもモアレと呼ぶ。(以上 Wikipedia)

左の図が典型的な、二本の平行線による交差角度が変わっていくときのモアレの発生の例だが(このGIF画像自体はGIMPで作成)、よく見ると、うなりのようなモアレだと思っている模様は、2本の線が交差するときにできる線が密な部分と粗の部分であることがわかるだろう。これは別にカメラの問題でなくても起きる目の錯覚というか実際にそうなっているので、偽色でも何でもない。

これが気になるのなら、人間の眼で見ても同じなので根本的に撮影方法を変えるか強引に修正するかになるだろう。

デジタル写真のモアレ

ただし、デジカメの場合は、撮影するものの模様のピッチとデジカメの持っている画素としてのピッチが近くて干渉すると目障りなモアレとなる。

この見本の写真を探そうとすると、ネットでは著作権が問題になりそうなものばかりで自分の撮った写真には、目立つものが意外と少ない。そこで安易にWikiに頼ることにした。

左がモアレが如何にも起きやすそうな模様の入った写真で、右がそれをモアレの起きやすい、整数でない半端な縮尺で縮小した写真で見事にひどいモアレが出来ている。

ただし、右の写真はWikiに載っていたモアレの見本の写真でなく自分で作ったモアレの写真である。

モアレが簡単にできるなら、表示の倍率を簡単に変えられる環境が当たり前の現代、もっと日頃からモアレに悩まされて良いはずである。

実は最近の写真編集ソフトやブラウザやビューワーでは、写真を縮小した時に出やすいモアレや拡大した時に出やすいギザギザは自動的に目立たなくする補間が行われる場合が多い。

上のモアレもGIMPで補間無しをわざわざ選ばないとモアレはほとんど目立たない。

試しにWikiからでもこのブログからでも、右の元の写真をダウンロードして縮小して見ても右のようなモアレがほとんど出ないだろう。(なお、このブログの写真は少なくとも個人で使い、外部に向かって著作権を主張するような非常識な使い方をしない限りは制限しない。もっともこの場合は、自分のオリジナルでなくのWikiの著作なのでWikiのGNUというフリーに使える規定になる)

最近のパソコンやスマホでは、補間機能が充実しているようで変なモアレはまず出ないようだ。

このモアレは、たまたま出てしまった場合だけ、その仕組みを理解して直せば良い。

偽色

それでは、最近はモアレは気にしなくて良いのかというと、まあ、昔ほど気にしなくても良いが実は根が深い偽色に関する問題がある。

これは、モニターと違って画素数を組で数えるのでなく、総数で数えてしまう見方によっては詐欺っぽいことと少し関係がある。

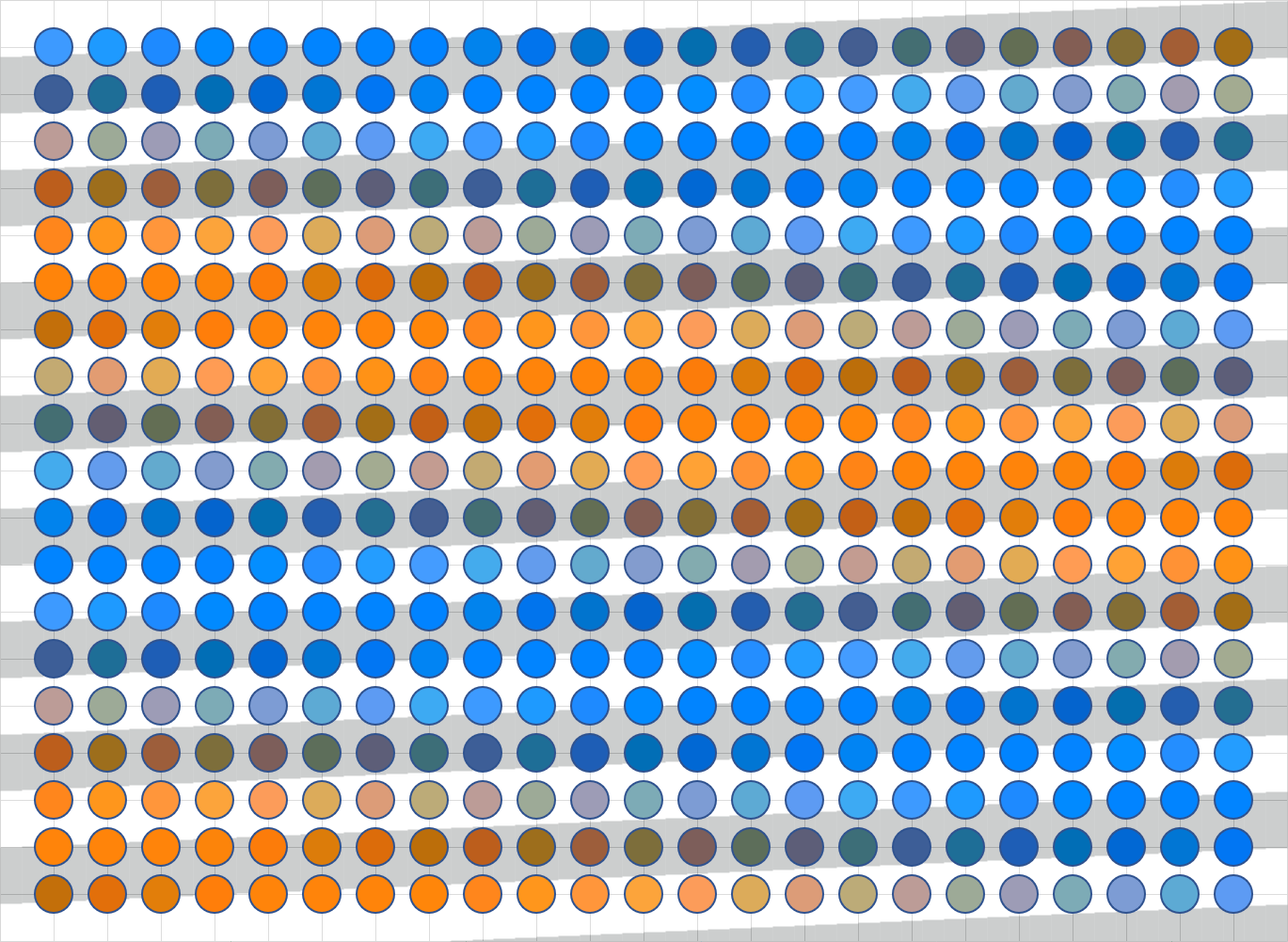

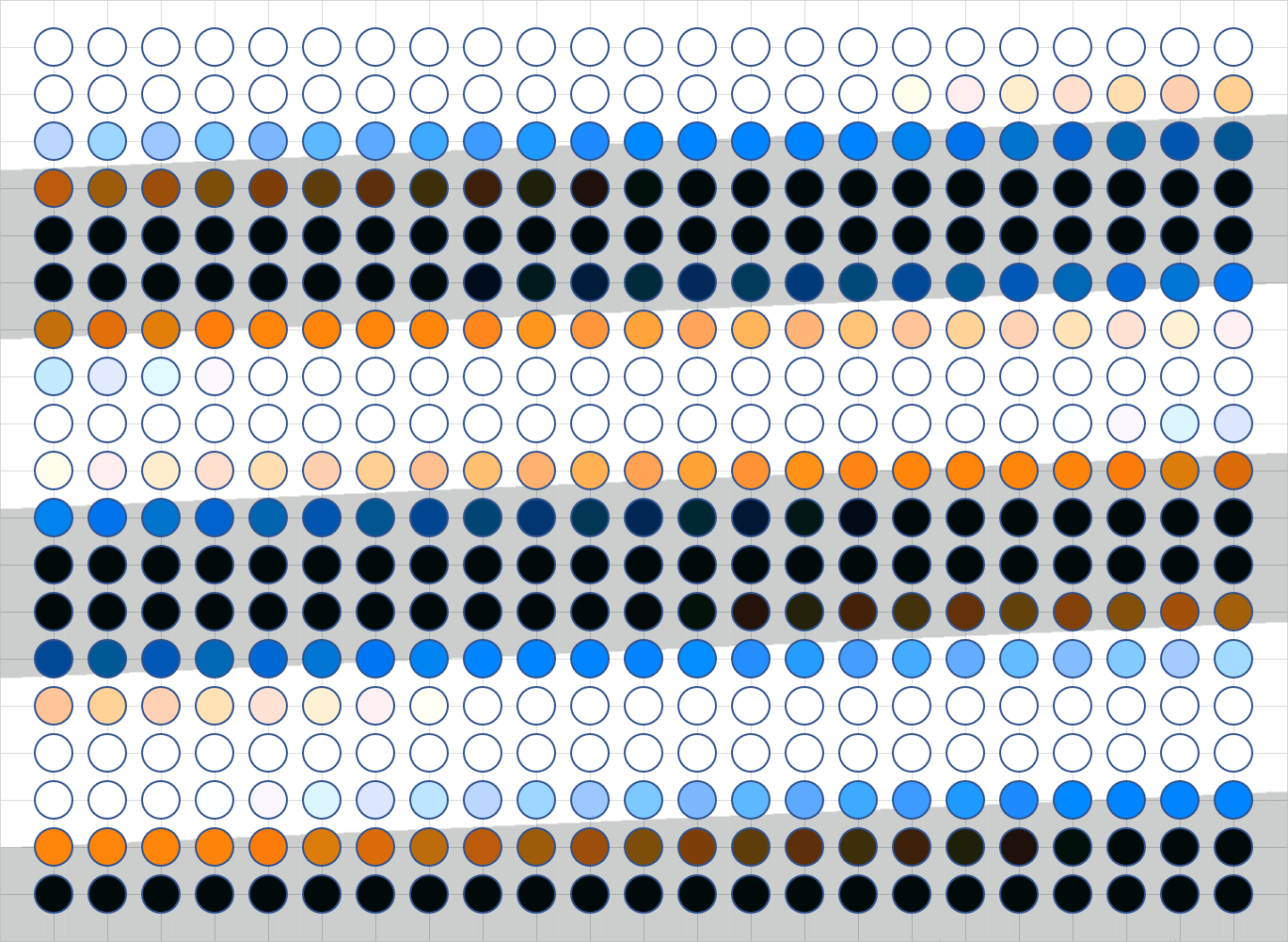

上の何やらあやしい図形は、すでに説明したByer配列のセンサーの入ってくる光をどのように処理して画素とするかを示した図である。

背景の何やら薄い色の、右に少し上がっている帯が光の入力パターンを示し、小さな四角の大きさが各センサーの取り込んだ入力量を表し、その色がセンサーの取り込む色を表す。

丸が周辺の四つのRGGBセンサーから取り込んだ色の値を合成した画素を示している。(センサーはこの区切られた面積全部に反応するのでなく、下と右に長さで20%の不感帯を設けている)

薄い灰色の直線がセンサーの1個の領域でその真ん中の小さい四角が色でセンサーの色を、大きさで取り込んだ光の量を表している。

薄い黄色や青色は入って来た光を表していて、水平より少し右上がりで斜めになっている。

画素は周りの4っつのセンサーの合成値である。標準的なBayerパターンなのでどこをとってもRGGBの一定の色センサーから成る。

最上段の行はR(赤)とB(青)のセンサーが交互に並んでいるが、入力光は黄色なのでRとG(緑)からなるのでBの入力は0である。

入力の色の境目は、影響を受けるセンサーは限られるので暗い緑や明るい赤の本来存在していない色が出る。

上の図を見ると結構この偽色ははっきり見えるが、目を細めて遠くからぼんやり見るとほとんど目立たなくなる。実際にはこんなにはっきり境界が出るほどレンズの性能は良くないだろうからもっと目立たないと期待して良いだろう。

しかし、入力光のピッチがもっと狭くなるととたんに偽色がはっきりと表れて来る。

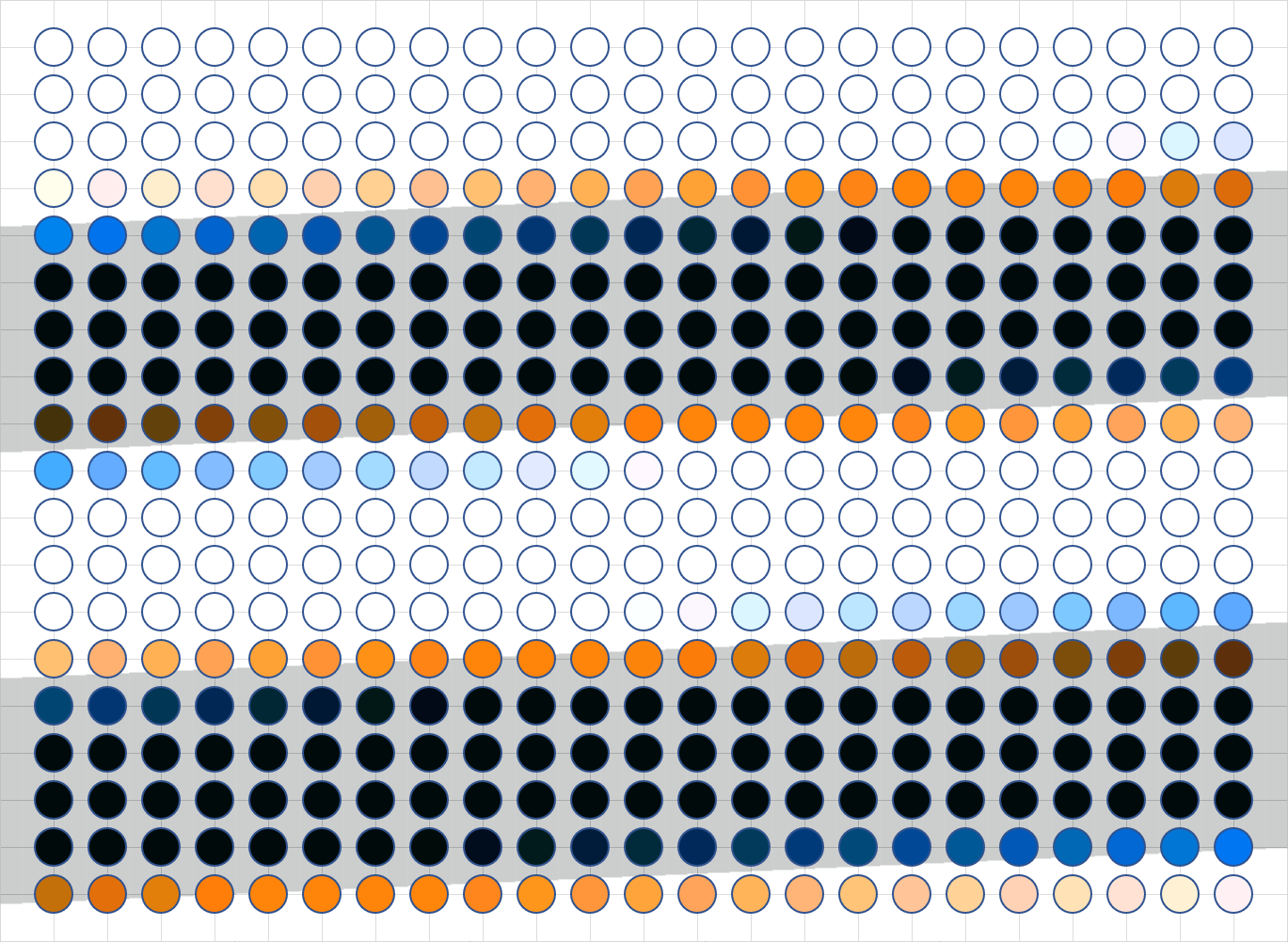

下の図は分かり易くするために白と黒の入力光にし、センサーの値はごちゃごちゃ鬱陶しいので省略して、入力光の幅をセンサーピッチに使づけた場合である。

これは偽色だらけである。入力光の幅はセンサーピッチの120%なので、2X2升でようやく全部の光の波長を収集することができるこの配列では正確に色を収拾出来ないのが当然だということがこの図でわかるだろう。

Bayer配列では緑のセンサーが多いので緑の色だけは光が点でなく帯状なので良く拾えている。

この偽色の解決策は、光が色の分解能以下の模様にならないようにすれば良い。つまりそれがローパスフィルターでセンサーの前において入力光の幅を広げることである。

ローパスフィルターは、見掛けはすりガラスなように見えるが、安いものならいざ知らず本来は、複屈折やら回析格子やらを使って高周波成分だけを周りに分配する板状の光学製品である(光学ローパスフィルターって何ですか?

ローパスフィルターを使わなくても一画素あたりに含めるセンサーの数を増やしても同じことである。画像のデータは数が巨大なので、まともに一個一個計算するととんでもなく時間がかかるが、専用の計算回路をすべてのセンサーの周りに追加することは、CMOSなら簡単にできるかもしれない。

なお、このプログラム(ExcelのVBAのマクロで、ちゃちゃっと作ろうとしたが、画像処理が貧弱で、追加のロジックを組むのに滅茶苦茶手間がかかった。Visual StudioのC#などでクラスを多用して作った方が簡単だったでしょう)を作った人の性格から真横の線にならないように描いているが図を見れば真横の光だろうと偽色が発生するのは明らかで、この偽色は線が斜めだからという問題でなく、色のセンサーが離れているからだということがわかる。

入力光の幅が広がるとどうなるかを示す。

入力光の境界は相変わらずシャープなままだが、それでもボーっと眺めれば大きく改善する効果がわかる。

画素数と解像度

結局、せっかくRGBの各素子を別々に数えるズルっこの画素数の水増しをしても、平面に色を分散していては、解像度はその分だけは出ないのである。

ただし、色の組み合わせはByer配列でも、隣の画素とは同じでないので分離はできているが、結局はモアレの偽色の方で解像度を下げざるを得ないのである。

フィルム写真では解像度はレンズとフィルムに分けて考える合理的な方法が当たり前のように行われていたが、デジタルカメラは、不十分なセンサー数から始まった経緯があるためか、大判カメラをほとんど駆逐するほどのセンサー数を持つようになった今は不毛な画素数でデジタルカメラの解像度を測る不毛な方法を重視しているなら見直すべきである。

デジカメで高性能なものは、光の波動とやらの性格を考慮するレベルに達している(回析など)など、多くの要素が絡まっているので結局は写った画をよく見て生半可な知識や見掛けにだまされないようにしたい。

Foveonなどの垂直に画素を配置する(カラーフィルも同じ)方法などを使わなければ,

この問題は基本的に解決しそうもない。

(なおFoveonも万能ではないようだ フォビオンセンサーの厄介さ)

ただし、ソフトの工夫なのかどうかはよくわからないが、最近のカメラは昔よりは解像度が上がっているのは間違いないようだ。実際には撮影したカメラの画をよく見て判断してもらいたい(レンズとの組み合わせも重要)。

まあ、最大の解像度は額面通り信用しない方が良いということは注意しておいた方が良さそうだ。

なお、最近はローパスレスを売りにしているカメラもあるらしいが、その実態については、デジカメにローパスフィルターは必要だが参考になるだろう。つまり撮像素子の進化にレンズの解像度がついていかないとローパスフィルターがいらないのでないか、というような話でこのサイトの話は結構視点が鋭そうである

色の問題 1.色の物理的な感じ方の問題

ここまで、写真はRGBの色のデータを使って表すことと当たり前のように扱ってきたが、それが実際の光を表す正しい方法かどうかは、実は大きな問題を抱えている。

センサーは波長別にフィルターされた情報を正確に把握し、人間もそれとよく似た波長別の3種の色の視覚細胞を持っている。色の問題の一部は、人間とセンサーの光に対する感度の差の問題だが、もっと厄介なのは、人間は色を単に光の波長の単純な分布でとらえていないことである。

たとえば、肌の色は、夕焼けの中で見ても日陰で見ても、部屋の中で見ても、別に酔っぱらって真っ赤かに見えて困るということも、病人のように青ざめて見えて困るという事もないが、波長だけでみれば、夕焼けの中の人は真っ赤だし、日陰では顔色が悪くなる。周りの光源が違えば当然反射されてくる光の波長の分布は異なる。

この問題を認識するには、人間が色をどのようにとらえているかという単に物理的な光の問題よりも複雑な事情を理解する必要がある。

しかし、まずは簡単な視覚細胞の特性から見てみる。

人間の眼は、明暗と色は別の細胞が感知していると考える場合が多いが物理量自体としては明暗と色の濃度に区別はない。

実際の光で自然光と呼ばれる太陽の光の成分のほとんどや電球などの温度によって光を発するものは、連続した波長(スペクトル)による強度を持ったものの集まりである。

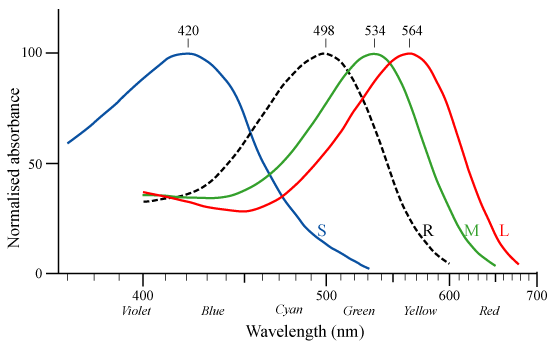

人間の眼はこの波長を連続的に隙間なく認識するのでなく、特定の波長の範囲に対して感度を持つ3種類の色をよく感じるが濃度には鈍感な錐体細胞の3っつの入力で色を区別し、これとは別に明暗の差に桁違いに敏感な杆体細胞によって構成されていると言われている。

左のグラフが各色の錐体細胞のおおよその感度分布と、黒の点線が明暗の差に敏感な杆体細胞の吸収スペクトルである。ただし、人によってこのグラフは同じでなく個性があるらしい。

左のグラフが各色の錐体細胞のおおよその感度分布と、黒の点線が明暗の差に敏感な杆体細胞の吸収スペクトルである。ただし、人によってこのグラフは同じでなく個性があるらしい。

図では錐体細胞の言い方でS(Short)、M(Middle)、L(long)とついているが光の3原色からBlue、Grenn、RedのRGBで表す場合も多い。特にデジタル写真の方ではRGBで表す言い方が主流である。

黒い点線は杆体細胞で明暗の差に高い感度を持っていると言われている。

色を三原色で表そうと言う昔からの考え方は、人間の色を感じる細胞が波長別に三つあることから発生した合理的な考えである。しかしこのカーブはきれいな山形でもないし、赤に相当するLのカーブは短波長側にも山がある。さらに杆体細胞の影響を無視していいのだろうか?

もし人間が犬やネコなどの多くの哺乳類と同じように、二つしか色細胞を持たなければ2色型色覚となり、多くの爬虫類や鳥類のように四つあれば4色型色覚となるらしい。すべての人間が3色色覚でないらしい。2色色覚の場合は、色覚異常として捉えられやすいが、4色色覚はなかなか区別されにくいが結構あり特に女性に多いらしい。色の分別作業は女性が向いていると言われるが、このことと関係があるのかも知れない。

物理的な面での色の問題をまとめると次のようになるだろう。

- 人間の眼はその一部の波長を独特のピーク特性(カーブ)で捉えている

- 人間の眼は色だけでなく主に明るさとして捉える杆体細胞も知覚に影響を与える

- 色を捉える機器も色を表現する機器も連続した波長としてでなく、ある波長の特性を持った要素でしか色を再現しない(ほとんどの場合この数は3原色の3だがそれ以外でもある)

この問題は十分難しいが、その前にもっと単純な問題を考えてみる。

色の問題 2:明暗の分解能(色深度)の問題

実際の光は、自ら発したり反射した光としてのエネルギーでセンサーはその絶対値に応じて値を出力するが、画像として記録するのは普通は絶対値でなく、標準の露光量に対する明暗差としての相対的な値でである。

これは、人間の眼が環境の明るさに応じて平均的な明るさを自動的に変えるからで、実際の木陰の黒紙が屋内の白い紙より多くの光を反射していても、屋内の白い紙は屋外の黒い紙よりは白く感じる。

さてデジタル写真では画像のデータはRGB各色に8bitずつ合計で24bitを1画素に使うというダイレクトカラー(インデックスカラーでない)方式のトゥルーカラー(TrueColor)と呼ばれる色深度(Color

Depth=画素を表すbit数)を使う。

たかだか24bitでTrueというのは、今となっては大げさだが、昔のコンピューターにとって画像のデータは巨大で24bitに落ち着くまでは、何とか少ないbit数で豊富な色を表すために、苦労したすえに、8bit x 3 =

24bitあればほぼ無限に色を表せると落ち着いたのである。

左は、英語版WikipediaのColor

depth(色深度)に載っているTruColorのAll

16,777,216 colorsである。

左は、英語版WikipediaのColor

depth(色深度)に載っているTruColorのAll

16,777,216 colorsである。

黒に近い部分の色はどこにあるのか、ちょっと疑問はあるが(この疑問以外ににもクリックして拡大すると、色が混ざらないようにだと思うが区別するための工夫がされているのがわかる)、少なくとも自分に取ってどこに文句を付けたらいいかよくわからない。

ただし、必要な色深度に関しては諸説あるようで、人間の視覚は10bitあるという主張を見た記憶がある(ま、私のことでないのは確かである)。

さて実際の写真では、写っているものをこの24bitの色に置き換えたものと考えれば良いのだが、話を簡単にするために白黒の場合を考えてみよう。白黒では3色の成分は等しいので8bit =

256種類の明暗で表現することになる。

一番明るいところは白で、R,G,B値で表すと RGB(255,255,255)という事になる。一番暗いことろはRGB(0,0,0)なので最大値は256でなく255である。

一番明るいところは白で、R,G,B値で表すと RGB(255,255,255)という事になる。一番暗いことろはRGB(0,0,0)なので最大値は256でなく255である。

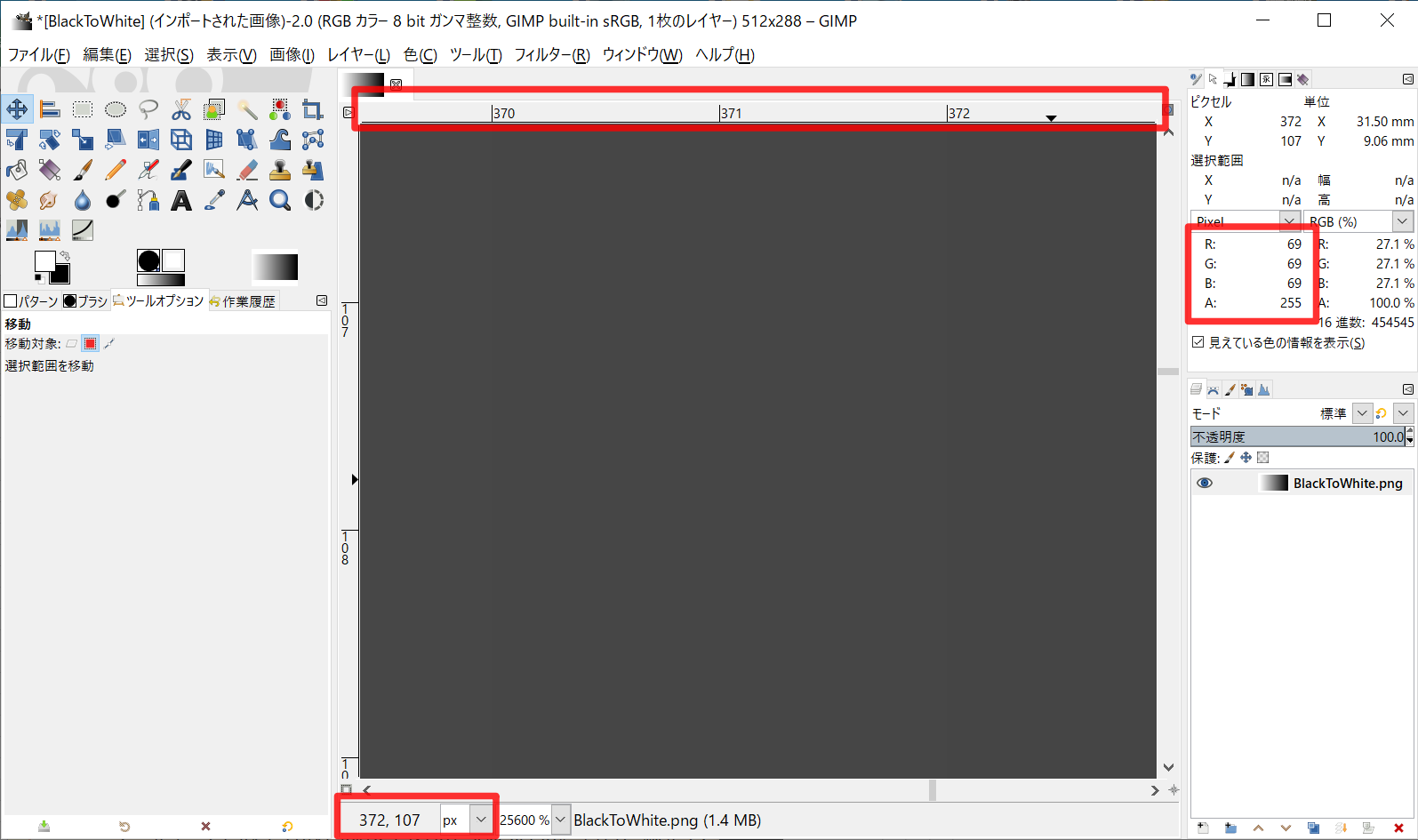

左の図がそのすべての256色を使ったグラデーションだが、これはモニターで表せる最大の明るさと暗さで、滑らかに明るさが変わって見れれば、これ以上に細かい明暗の表現能力があっても役に立ちそうもないという事になる。これはGIMPなどの画像編集ソフトを使えば簡単に調べられる。

データ自体は、GIMPでRGB(255,255,255)からRGB(0,0,0)でできたPNG画像なので色に関しては正確なビットマップデータで横幅256ピクセル以上あれば正確に白黒の明るさの変化を表しているはずである。

データ自体は、GIMPでRGB(255,255,255)からRGB(0,0,0)でできたPNG画像なので色に関しては正確なビットマップデータで横幅256ピクセル以上あれば正確に白黒の明るさの変化を表しているはずである。

GIMPで左図のように拡大して見ればスケールにピクセル値を表示した上でマウスの位置のRGB値を表示できる。GIMPで見るのが面倒ならば左図自体PNG画像で正確なビットマップデータなのでクリックして拡大するとGIMPで見ているのとほぼ同じ画像が見れる。

もし、上のスケールの370と371の数値の下に真下に向かって濃度の違いの線が見えたら実際に明暗の違いが区別できたという事になる。データ上は色の境目は左図の範囲だとこの部分にしかない。

真っ白と真っ黒のあたりはモニターの限界か見分けがつきにくいが中間付近は、見分けやすい条件であれば、この色深度では不足する場合もモニターと人によっては多いだろう。

もっともこれはきっちりとした画像データなので見分けやすいということはあるだろう。

モニターも単純にRGBを表示しているわけではなく、モニターの特性に合わせて表示したり、安いコストでより良い表示を目指すなど結構複雑で、モニターの色の設定項目もたくさんある、設定によって見え方が変わるという点に注意して、実際に自分のモニターの実力がどの程度のものかは、色々な素材を見て確認した方が、少なくとも写真を人に見せようと思うのなら確認した方が良い。ただし、人間の眼は順応性が高いので今の24bitの色深度の中でなら、それほど違和感なく使える場合が多い。モニターの設定で色を変えてきれいさが変わったと思ってもすぐに慣れる。

EIZOはこの最大表示色についてのページ以外にも詳しい解説が多い。

写真を扱うモニターは8bit表示より10bit表示の方が良いのかどうかどうかも24bit以上の色深度が良いと決めつける前に見ておいた方が良さそうだ。

撮影時の色深度

モニターは24bitの色深度で良い(我慢?)として、撮影時は表示とはまた別の考え方がある。

たとえば、かみさんの写した左の昔の写真では、全体としては露出はそんなに間違っていないが、逆光なので手前の船のディティールはほぼつぶれている。こういう時は自分なら露出を少し開けて撮るのが鉄則だが、ま、うちのカミさんなのでそんなことはお構いなしである。

たとえば、かみさんの写した左の昔の写真では、全体としては露出はそんなに間違っていないが、逆光なので手前の船のディティールはほぼつぶれている。こういう時は自分なら露出を少し開けて撮るのが鉄則だが、ま、うちのカミさんなのでそんなことはお構いなしである。

このとき、もしカメラがもっと広い範囲で=明るいところから暗いところの範囲まで幅広くとっていてくれれば、明るいところのトーンも暗いところのトーンも失われずに済んだはずである。

昔のフィルカメラの「写ルンです」などはフィルムの幅広い明暗差を記録する能力を利用していい加減な露出でもプリントするときに適当な範囲を印画紙に移してくれるので、こういう写真でも船のつぶれを補正をし易い。

ただし、デジカメ写真では現像もプリントもなしに気軽に見れるのが特徴なので明るいところから暗いところまで同時に24bitの色深度に収めようとすると明るいところと暗いところの明暗差が実際よりも狭くなって、コントラストの弱い眠い写真になりそうである。

このあたりは露出のEV値の考え方である光の強さを対数表示で考えると分かり易い。人間の光の感じ方は比率で感じるようなので、たとえば1lux(ルクス)という暗い夜道程度の明るさでは2kuxの明るさは十分に違いがわかるが、曇りの屋外では10000luxくらいの明るさの元での10001kuxとの差など誤差としても感じない程度の明るさの差であるが、その差を対数グラフではきちんと分かり易く表示できる。

たとえば一目盛りを2倍とすると、1luxの1段上は2luxだが10000luxでは20000luxになる。一段階を2倍でも10倍でも目盛の間隔が変わるだけで全体の分布はまったくおなじになるのも対数表示の特徴である。カメラでよく使うEV値は2倍の系列なので写真をやっている人にとっては2倍の系列がわかりやすいだろう。

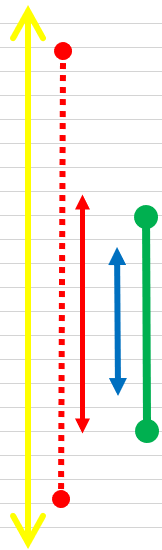

明るさの対数表示

さて左図で、黄色の矢印は自然界の写る対象となり得る光の量の範囲を表している。明るい方はきりばないので矢印でまだまだ続くことを表している。

さて左図で、黄色の矢印は自然界の写る対象となり得る光の量の範囲を表している。明るい方はきりばないので矢印でまだまだ続くことを表している。

暗い方は対数表示では、たとえば半分の半分は無限に小さくなりながらも続くので0は無限の彼方になるのでそれを矢印で表してる。

赤の点線は人が慣れれば見分けられる範囲の明暗で、個人差や体調による差はあるにしても上も下も限界があるので端は丸にしてある。

この範囲は同時に見分けられるわけでなく明順応、暗順応という時間がかかる人間内のプロセスによって見ることができるようになりいちどきに見分けられる範囲を赤の実線で表す。これは赤の点線の範囲内で上下する。

矢印のついた青の線は、モニターや印画紙などの表示媒体で表すことのできる明暗の範囲である。これは、装置や周りの明るさによって範囲が変わるが、範囲の大きさはそれほど変わらず、人間が一時に見分けられる範囲に近ければ問題ないはずである。

緑の太い線がデジタルカメラで記録する明暗の範囲で、露出によって上下に移動する。範囲の大きさは、性能や設計によって変わる。この範囲より上の明るさは最大の白になり下は最大の黒になる。

写真の場合は、この緑の線の範囲だけが写るというわけでなく、この範囲より上の光は真っ白、下は真っ黒になって単に明るさを区別できないだけであるという点に注意が必要である。

したがってこの緑の範囲は、人間の見える範囲と無関係に明暗の差を正確に写し取れる範囲と考えても良い。

もし、デジタルカメラがものすごく広い範囲の明暗を写すことができ、しかも十分な明暗の差を記録できるならば、写ルンですのようなカメラと同様に撮った後で自由に現像なり引き延ばしなりの作業で好きなように青の範囲に落とし込むという、すごすぎる方法が使えることになる。

残念ながらこの方法には現実的なデメリットがいくつかあるので、めでたし、めでたしとならない。

RAW画像とHDRに明暗の拡張

カメラによっては、RAW画像として通常の24bitの色深度のJPGデータだけでなく、各色10bit程度のデータを別途記録できるものが結構ある。

広い明暗差を記録するのは、センサーは露光時間や絞りだけでなく感度も変えられるので、赤の実線以上に広げるのはそれほど難しくないだろう。事実自分が日頃使っているカシオの安いコンデジでさえもRAWで記録できる。

問題は、通常の色深度の24bitに落とし込むまでの方法である。ただでさえ大きい画像ファイルのサイズをさらに6bitもサイズを増やさなければいけない。それも下手に圧縮すると意味がないのでサイズは30bit/24bit以上に膨らむ。CASIOのEXLIM EX-ZR1100でサイズが5~6倍。Olympus E-5Mk2で2倍強のファイルサイズになる。当然保存時間は増える。確かに暗部やハイライトの描写は改善するが、RAWを普通の24bitのJPGにしないと普通に見れる写真にならないのでその画像処理にまたかなりの時間がかかる。

もし、この30bitのシステムに合わせたモニターと画像形式とが普及し、処理するハードウェアの性能もこれに合わせて進歩すればより普通に見れる日が来るかもしれない。

しかし、それよりも実際の上限と下限側の明暗差を伸ばして、明部と暗部の情報を圧縮する形で幅広い明暗差に対応して24bitのJPGをカメラが吐くというのがより現実的かもしれない。

その方法のひとつがHDRと呼ばれる技術で、監視カメラではかなり普及している方法である。

HDRについて詳しくはWikiの該当ページなどを見てもらいたいが、以下に見本を示す。

右のHDRの方が暗部の濃度が薄く、ほぼごみのようなきたないものまではっきりわかる。

ただしこうして比較できる形で見ると、右の方はコントラストがなく画が眠いと思う人もいるだろう。

ただし、モニターの明暗のコントラスト比が大きいモニターでみれば当然改善される。

もっと、考えれば、並べているから気になるので、ひとつずつ見ればそれほど気にならないかもしれない(もちろんモニターにもよるが)。

試しに右の写真をクリックして拡大して見てもらいたい。

どうですか? それでもコントラストが弱く感じますか?

人やモニターの差があるので単純に決められないが、意外と人間って、視覚に関して順応能力が強いとおもいません?

色域

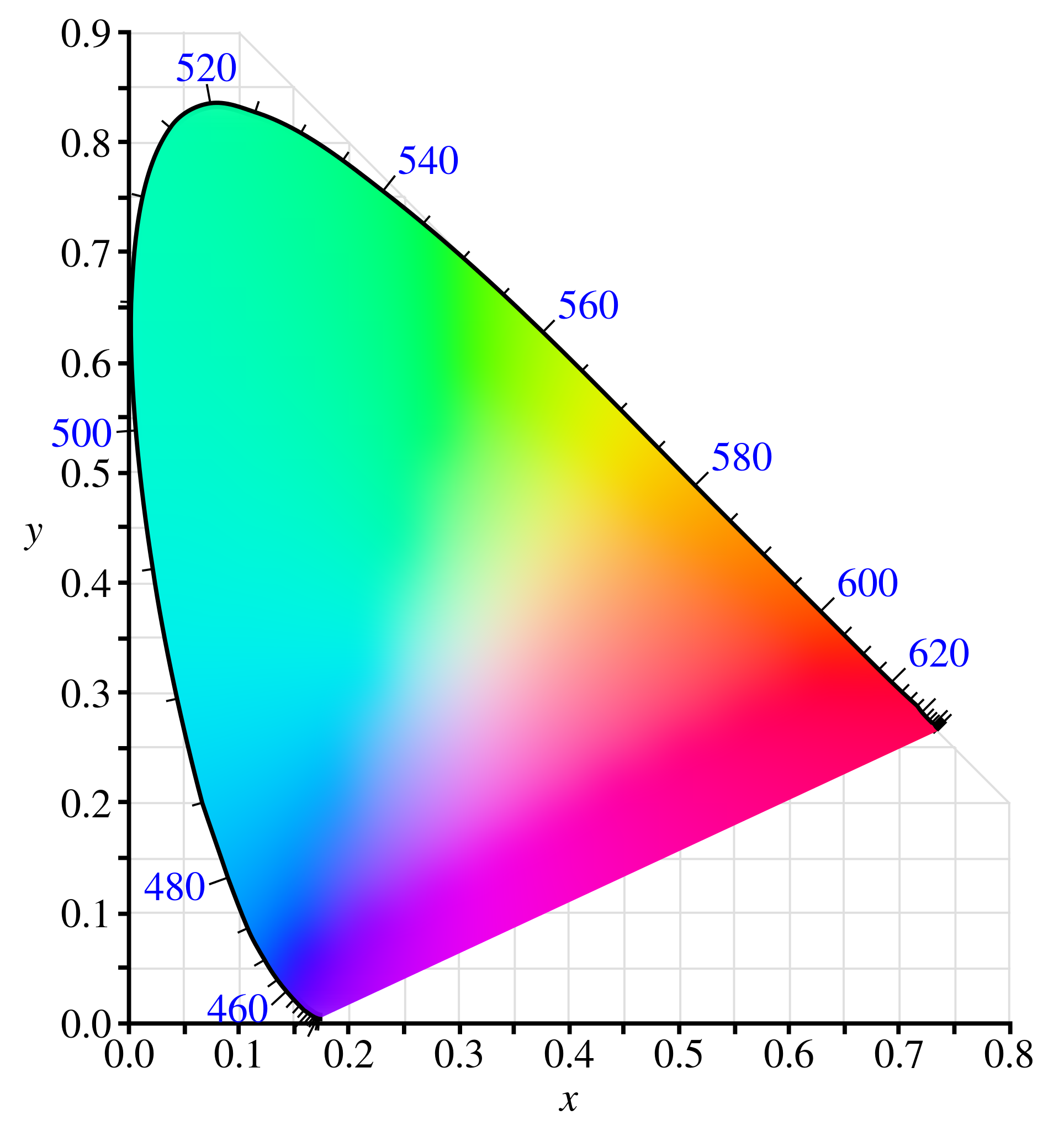

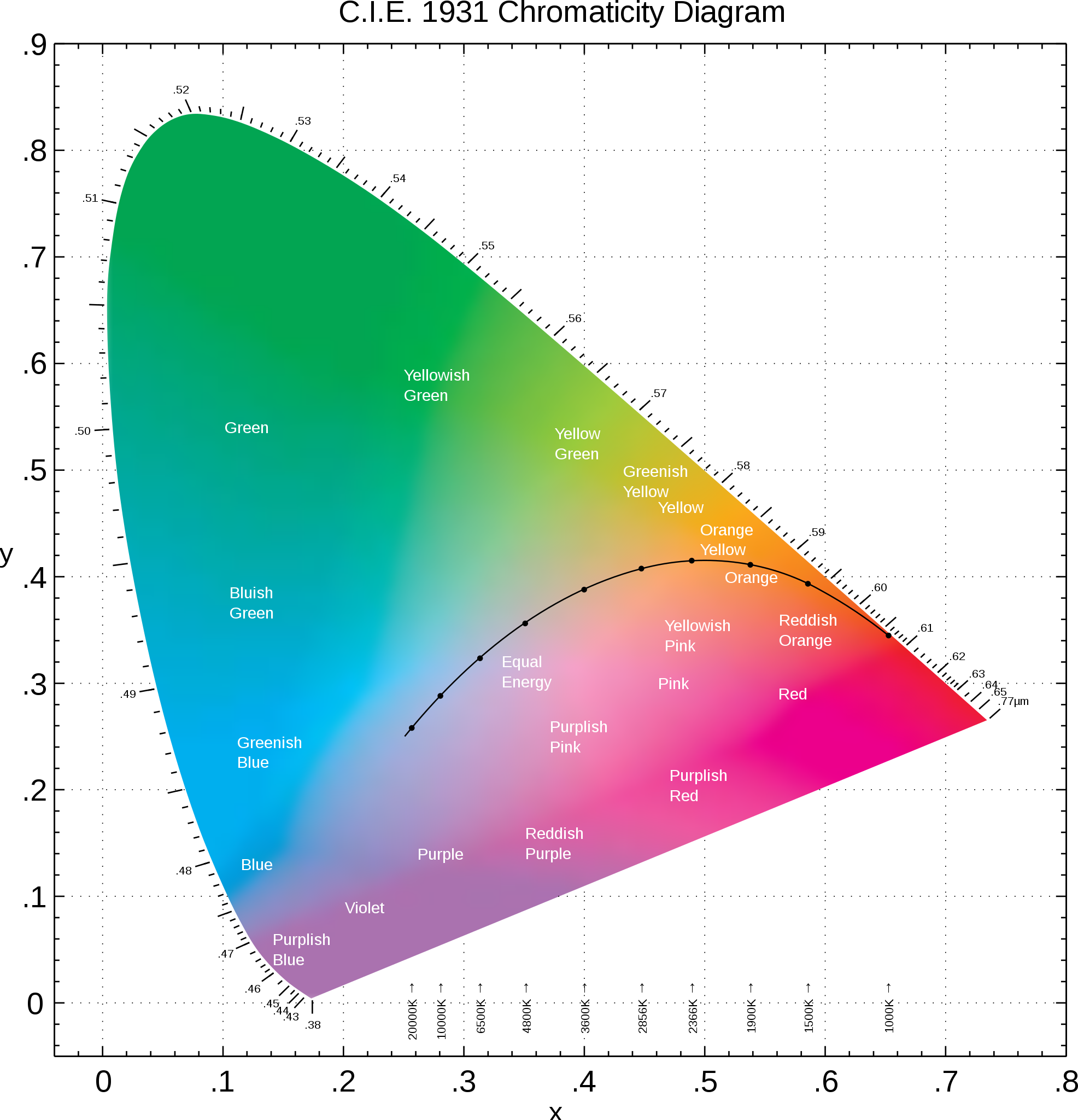

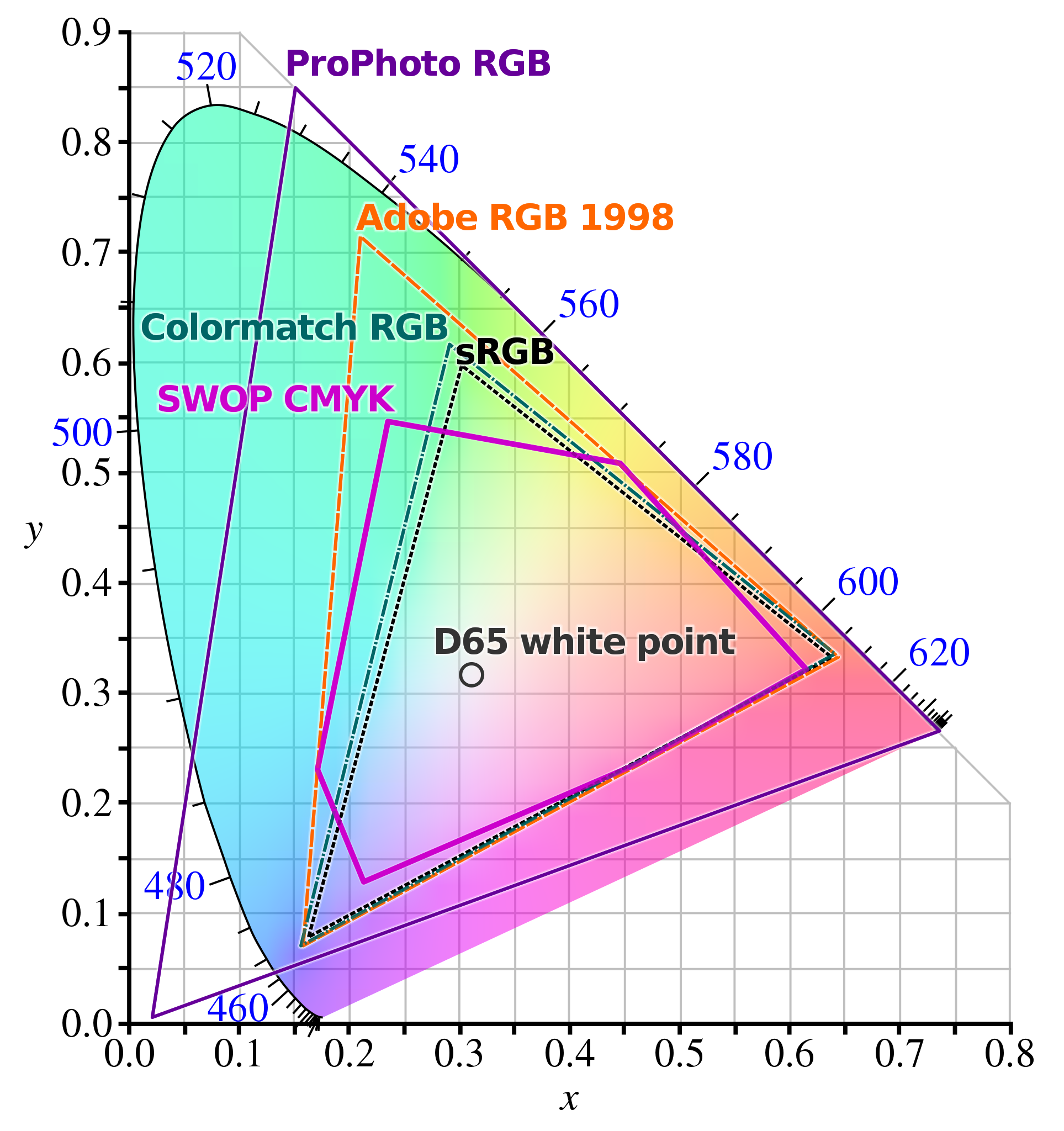

色域は色の範囲のことであるが、よくわからない言葉である(ここの図もクリックで拡大)。

色を表す機器でよく出て来る右の色域図は、CIE(国際照明委員会:Commission internationale de l'éclairage)で規定された色度図である。

色を表す機器でよく出て来る右の色域図は、CIE(国際照明委員会:Commission internationale de l'éclairage)で規定された色度図である。

ただしこの図もCIEで規定された印刷などの低照度下で使われことを意図した色度図である。

ただしこの図もCIEで規定された印刷などの低照度下で使われことを意図した色度図である。

この図は、SRGBやAdobeRGBだからどうのこうの、ICCがあっていないといけないなどと言うときによく見るこの色空間の中の一部を指すときの範囲が示されている。

この図は、SRGBやAdobeRGBだからどうのこうの、ICCがあっていないといけないなどと言うときによく見るこの色空間の中の一部を指すときの範囲が示されている。

色って写真では結構大事なもののはずなのに、こういう色域の話は、本当にわかって説明しているのかというのも含めて何を言っているのかよくわからない難しい説明が多い。

確かに同じ写真でもモニターやプリント(フィルムでもデジタルでも)、カメラ、さらに同じカメラでも設定が違えば別の色味になるということは良く経験する。

これを何とかした方が良いのは理解できるが、実際ICCが合っていたからと同じ色みになるとは限らないし、モニターによっては、色の調節を使用とするほど、色の再現性のひどさに気が付くだけのときもある。

人間の色の捉え方は、完全なスペクトラムでなく代表的な分光特性を持った視細胞での結構複雑な信号変換と脳で行っている特殊で複雑で現在のAI処理よりも複雑な処理回路によると考えていいだろう。

しかも実験による色のスペクトラム感度は、普通はあってはいけない負の感度領域があることを示しているらしい。

自分でできる説明は、この程度なので、詳しい説明は、以下のサイトを見て欲しい。

まずは、まあまあ簡潔だが、ある程度わかっている人でないとあまり役に立たないかもしれない一般的な説明サイトを示す

- Wikipedia:CIE 1931 色空間 この図の説明

- Wikipedia:CIE Luv色空間 CIEのさらに新しい規格

- Wikipedia国際照明委員会 CIEについて

- CIEのホームページ(英語)

- Wikipedia(英文):Spectral sensitivity

分光感度の説明。日本語の分かり易いサイトが見つからないので英語のページ- Wikipedia:インターナショナル・カラー・コンソーシアムいわゆるICCプロファイルを作った団体

上でさっぱりわからないという場合は、丁寧に説明している以下のサイトがお勧め。

いきなり結論を示さずに順を追って説明しているのでじっくり読めば理解しやすいが当然のように長い。お勧めは最後のサイトの最初の方。人間の色の捉え方の問題を身をもってつまされる程度には分かり易く書いてある。

- XYZ色空間に迫る(1) 色についての科学的にかなり明解な説明。理解するには数学的素養が必要になるが、説明は分かり易い。

- 光と色の話 第一部上からも引用されているシーシーエス株式会社の色の話のトップページ。感謝 m(_ _)m

- KONICA MINOLTA 色色雑学昔、コニカミノルタは色の測定器を昔から作っていたが、そこが昔出していた、カマラマン程度でも分かり易い「色の本」を出していたが、それを発展させたWEB版か?

色に関しては、同じICCプロファイルでもどこが同じ色なんだと思うことはしょっちゅうのようで、結局は普通の人にとっては、せめて実際に自分の眼で確かめることが肝要かと。それと良いモニターは発色が結構よく見える場合が多いように見える。

色温度

色温度に関してはフィルムカメラをちょっとやって来た人間なら、そしてリバーサルカラーフィルムのような引き延ばし時に調整が効かないものを撮ってきた人なら、いやになるほど実感させられたことだろう。

人間は、色の判定に関しては記憶に基づいて色を補正して感じるので、真っ赤な夕日の元で人を写しても、酔っぱらいのように顔が赤いとは思わない。それをそのままデジカメで色補正を自動で無しにして撮影すると真っ赤っかに写る。曇りの日は青っぽく写る。

これは、人間の視覚は光源が赤っぽかったり青っぽかったりして偏っていても、自動的に補正するすごい能力が備わっているからである。

この能力のすごさは赤色や青色のセロファン紙があれば簡単に実感できる。赤か青のセロファンをどちらかの目に数分間かけて置く。

最初はセロファンを掛けた負の色が不快なほど狂っているように感じるが、数分すると違和感が薄れて来る。片目を交互に閉じて見ると再保ほどの違和感が無くなっているのがよくわかる。

違和感が無くなったら、セロファンを一気に取ると、あら不思議、赤色のセロファンだった場合は、そちらの眼の色が真っ青に、青色だったら真っ赤になる。

セロファンを取ったのに、セロファンを付けた時の違和感と同じような感じがするはずである。初めてのときは、ちょっとショッキングで自分の眼が壊れたと思うかも知れないが、時間が立てば正常に戻る。

安物のセロファンでも色はちゃんとフィルターしているはずなので、これは目が内部で物理的だか科学的だかの処理か、脳内でソフト的に処理してるのか、良く知らないが、とにかく人間が持っている思い込みなどというレベルでない、色に関して明確な処理を、それも高度としか思えない処理をしている証拠である。

デジタルカメラといえども、これほど複雑な処理は出来ないが、幸い、すべての色を平均したら灰色になるはずだというようなことを利用した結構単純な自動の色温度補正が結構役に立つ(家庭用のカラーホームビデオの初期のころから存在していた)。

色に関しては、人間は記憶色などと呼ぶ、記憶に基づく色補正能力を持っているといわれ、たとえば桜の花びらは、正確に色を再現してもクレームが来るといっていいたデジカメの開発者がいたが、結構厄介な問題である。

もっとも、人間は人間で写真を見るときでも優れた補正機能が働くはずなので、気になる場合には、画像編集ソフトで修正するくらいに考えておいた方が良い。

最近のカメラでは大概の場合には、大きな不便はないはずだが、それでも良い写真にしようとすると最後は、人間の能力を駆使した方が良い。

そのために画像編集ソフトの使い方は大事である。

次のページ:デジタル写真の画質について